전체 분야

도서분류

컴퓨터/IT > 컴퓨터공학 > 인공지능 > 인공지능일반

컴퓨터/IT > 대학교재

대학교재 > 컴퓨터

컴퓨터/IT > 대학교재

대학교재 > 컴퓨터

도서소개

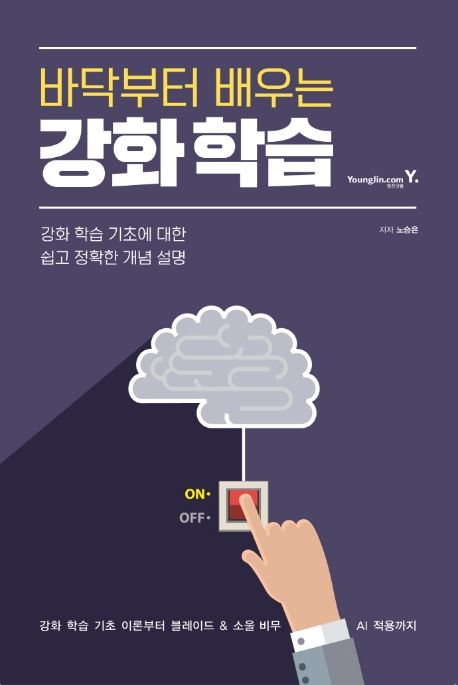

강화 학습 기초 이론부터 블레이드 & 소울 비무 AI 적용까지

이 책은 강화 학습을 모르는 초보자도 쉽게 이해할 수 있도록 도와주는 입문서입니다. 현업의 강화 학습 전문가가 직접 설명해 강화 학습에 가장 기본이 되는 개념 설명부터 실무 사례까지 한 권으로 정리했습니다.

강화 학습의 뼈대가 되는 MDP부터 딥러닝과 강화 학습이 만나는 지점 및 학습 방법론, 알파고, 알파고 제로까지 다룹니다. 나아가 유명 게임인 블레이드&소울 비무에 실제로 강화 학습을 적용하며 실무에서 얻은 팁과 노하우를 배워봅니다.

추천사

이원종 (서울대학교 지능정보융합학과 교수)

강화 학습은 고전적인 이론들이 바탕이 되면서도 문제마다 적절한 해결 방안이 다른 매우 재미있는 분야입니다. 딥러닝과 접목된 이후 방대한 분야에서 활용되고 있는 현 시점에, ‘바닥부터 배우는 강화 학습’은 많은 분들에게 기초 이론과 그 응용을 위한 최고의 입문서가 될 것입니다

이상우 (네이버 Clova AI Research 기술 리더)

현업의 강화 학습 전문가가 전하는 강화 학습의 생생한 이야기. 친절한 설명과 자세한 디테일을 동시에 겸비한 책. 강화 학습의 이론적인 기초부터 실무적인 사례까지 폭넓게 다루고 있습니다.

곽동현 (네이버 Clova AI / 서울대학교 BILAB 박사(수료))

아주 직관적인 말과 예시로 강화 학습의 핵심 기초를 촘촘히 모아두었습니다. 유행하는 최신 기법들은 언제나 빠르게 생겨나지만 근간이 되는 기초는 결코 쉽게 변하지 않는다는 점에서, 이 책은 오랜 시간이 흘러도 그 가치를 잃지 않을 소중한 책이 될 것입니다. 강화 학습을 꿈꾸는 이들에게 가히 최고의 책이 아닐 수 없습니다.

상세이미지

저자소개

저자 노승은

민족사관고등학교 졸업

서울대학교 자유전공학부 컴퓨터공학/경제학 전공

서울대학교 융합과학기술대학원 석사

현) 엔씨소프트 GameAI랩 강화 학습 연구원

현) 강화 학습 유튜브 채널 “팡요랩” 운영

목차

Chapter 1. 강화 학습이란

Chapter 2. 마르코프 결정 프로세스

Chapter 3. 벨만 방정식

Chapter 4. MDP를 알 때의 플래닝

Chapter 5. MDP를 모를 때 밸류 평가하기

Chapter 6. MDP를 모를 때 최고의 정책 찾기

Chapter 7. Deep RL 첫걸음

Chapter 8. 가치 기반 에이전트

Chapter 9. 정책 기반 에이전트

Chapter 10. 알파고와 MCTS

Chapter 11. 블레이드&소울 비무 AI 만들기

서평

[구성 소개]

Chapter 1. 강화 학습이란

바둑에서 시작하여 게임, 금융, 로봇까지 수많은 분야에서 강화학습을 통해 전례 없는 수준의 AI가 만들어졌습니다. 기존 학습 방법론과 어떤 차이가 있었기에 이런 도약이 가능했을까요? 그에 대한 답은 강화 학습이 무엇인가라는 작은 이야기부터 시작합니다.

Chapter 2. 마르코프 결정 프로세스

문제를 풀기 위해서는 먼저 문제가 잘 정의되어야 합니다. 강화 학습에서 문제를 잘 정의하려면 주어진 문제를 MDP(Markov Decision Process)의 형태로 만들어야 합니다. MDP에 대해 속속들이 알아봅니다.

Chapter 3. 벨만 방정식

대부분의 강화 학습 알고리즘은 밸류를 구하는 것에서 출발합니다. 그리고 밸류를 구하는 데 뼈대가 되는 수식이 바로 벨만 방정식입니다. 벨만 기대 방정식과 벨만 최적 방정식이라는 두 종류의 방정식을 배워봅니다.

Chapter 4. MDP를 알 때의 플래닝

벨만 방정식 학습으로 간단한 MDP를 풀 수 있습니다. 벨만 방정식을 반복적으로 적용하는 방법론을 통해 아주 간단한 MDP를 직접 풀어봅니다.

Chapter 5. MDP를 모를 때 밸류 평가하기

MDP의 전이 확률과 보상 함수를 모를 때에 대한 이야기가 시작됩니다. 주어진 수식을 이용해 정확한 값을 계산하는 대신, 수많은 샘플을 통해 근사하는 “샘플 기반 방법론”을 배워봅니다.

Chapter 6. MDP를 모를 때 최고의 정책 찾기

Control 문제를 해결할 차례입니다. 밸류를 계산할 수 있기 때문에 이를 이용해 정책을 찾는 것은 한결 쉽습니다. 그 유명한 Q러닝을 배워봅니다.

Chapter 7. Deep RL 첫걸음

커다란 MDP의 세계를 항해하기 위해서 우리에게는 또 다른 무기가 하나 필요합니다. 바로 “딥러닝” 입니다. 딥러닝과 강화 학습이 만나 Deep RL이라는 유연하고도 범용적인 방법론이 탄생합니다. 먼저 딥러닝에 대한 이야기부터 시작합니다.

Chapter 8. 가치 기반 에이전트

신경망을 이용해 액션 밸류 네트워크를 학습하면 그게 곧 하나의 에이전트가 될 수 있습니다. 아타리 게임을 플레이 하던 DQN이 바로 이 방식입니다. 가치 함수만을 가지고 움직이는 에이전트, 즉 가치 기반 에이전트에 대해 알아보겠습니다.

Chapter 9. 정책 기반 에이전트

딥러닝과 정책 함수가 결합하면 강력한 정책 네트워크를 만들어 냅니다. 보상 및 밸류 네트워크를 이용해 직접적으로 정책 네트워크를 학습하는 방법에 대해 알아보겠습니다. 이는 수많은 최신 강화 학습 알고리즘의 뿌리가 되는 방법론입니다.

Chapter 10. 알파고와 MCTS

인류 최고의 바둑 기사를 이긴 AI를 만드는 과정도 분해해서 생각하면 간단한 방법론들의 조합입니다. 이제 한 걸음만 더 가면 알파고를 완전히 이해할 수 있습니다. 그 마지막 한 조각인 MCTS를 소개하고, 이를 통해 알파고를 낱낱이 분해합니다.

Chapter 11. 블레이드&소울 비무 AI 만들기

복잡한 실시간 격투 게임에 강화 학습을 적용하는 일은 어떤 과정을 거칠까요? 블레이드&소울에 강화 학습을 적용하여 에이전트를 학습시키는 과정과 시행착오에 대해 소개합니다.